機器學習模型無法再現人類關於規定違反的判斷

研究發現機器學習模型在評估違反規定時,與人類判斷存在巨大差異

人工智慧(AI)和機器學習模型在決策方面越來越常用,例如評估社交媒體帖子是否違反有害內容政策。但是麻省理工學院的研究人員發現,這些模型通常無法再現人類關於規定違反的判斷。如果模型沒有得到正確的資料訓練,它們往往會做出不同,通常更苛刻的判斷。

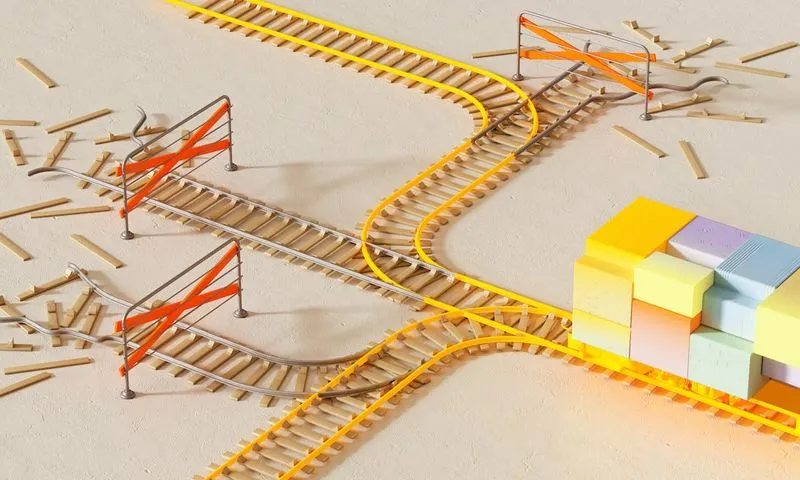

正確的資料是由人類標記的,他們明確被要求評估物品是否違反特定規則。此類“規範資料”的數百萬例被用於訓練機器學習模型。但是通常用於訓練機器學習模型的資料是以描述性標籤標記的-這意味著人們被要求識別事實的特徵,例如照片中是否有油炸食品等等。如果使用“描述性資料”來訓練評估是否違反規定的模型(例如,判斷一頓餐是否違反禁止炸食品的學校政策),這些模型往往會過度預測違規情況,導致準確性下降,對現實世界產生嚴重影響。

資料的標注不同可能導致模型的偏見及準確性下降

研究小組發現,在描述性環境中,人們更有可能將某個物體標記為違反規定。研究人員訓練了兩個不同的模型,一個使用描述性資料訓練,另一個使用規範資料訓練,然後進行比較。他們發現,如果使用描述性資料來訓練模型,它將表現不如使用規範資料進行相同評估的模型。特別是,使用描述性資料訓練的模型更可能在假設有違規行為的情況下,錯誤地預測違規行為。

對資料透明度進行改進是緩解這個問題的一種策略。如果研究人員知道資料是如何收集的,那麼他們也知道這些資料應該如何使用。另一種可能的策略是將描述性訓練模型微調到一小部分規範資料,這是研究人員未來研究的方向之一。

研究結果表明:機器學習模型的應用需要仔細考量其資料訓練過程,並透明地呈現實驗結果,以緩解這種問題。

延伸閱讀

- 加州新 AI 法案出爐,SB 1047 作者再推出改革措施!

- 《超級瑪利歐成為 AI 基準測試的新標準!你絕對想不到的理由》

- Google 推出 SpeciesNet:專為識別野生動物而設的人工智慧模型!

- 安瑟普提克獲得 35 億美元巨額資金 瞄準人工智慧未來!

- OpenAI 重磅推出 GPT-4.5:歷史上最大的語言模型來了!

- 探索 DeepSeek:你必須理解的 AI 聊天機器人應用全指南!

- OpenAI 的創業帝國:揭密其風投基金背後的諸多創新公司

- 揭開 Mistral AI 的神祕面紗:揭示 OpenAI 競爭者的所有祕密!

- 未來科技:研究人員揭示如何打造變形機器人,猶如 T-1000 般神奇!

- ElevenLabs 推出全新語音轉文字模型,引領 AI 語音技術的新潮流!