研究人員警告 AI 模型訓練中的模型崩塌問題

背景

在 OpenAI 的 ChatGPT 技術推出六個月後,全球一些領先企業的高達一半員工使用了這種型別的技術來協助工作流程,而其他許多企業也急於推出內建生成式人工智慧(generative AI)的新產品。然而隨著越來越多的人使用 AI 來製作和發布內容,一個不容忽視的問題浮現:當使用 AI 生成的內容在網際網路上大量增長時,當 AI 模型開始基於這些內容進行訓練時,會發生什麼?

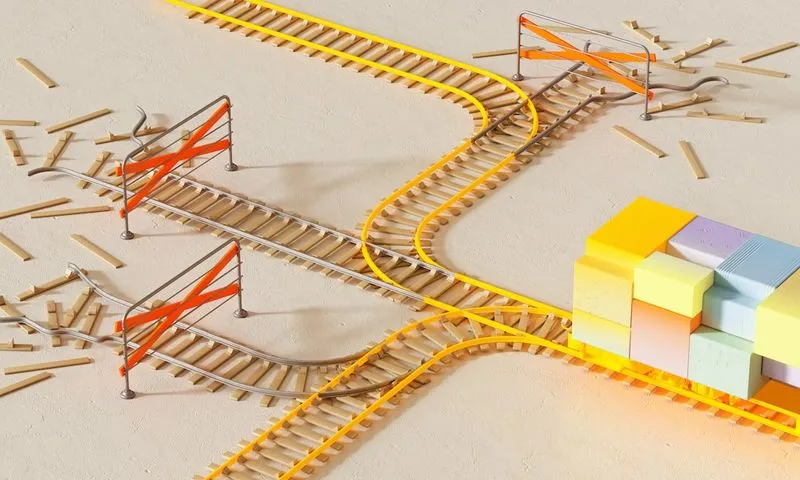

近期,一組來自英國和加拿大的研究人員探討了這個問題,他們在開放存取期刊 arXiv 上發表了一份論文。他們發現現有 generative AI 技術存在模型崩塌問題,也就是模型的逐步退化,而這會對 AI 相關產品產生嚴重影響。

模型崩塌的原因

簡單來說當 AI 模型開始訓練後,由其生成的資料最終會污染後續模型的訓練資料集。Ilia Shumailov 是這份論文的主要作者之一,他透過在 Google 等平臺上進行類比來解釋模型崩塌的原因。例如,在訓練資料集中,有 10 張藍色毛皮貓的圖片和 90 張黃色毛皮貓的圖片。模型學會了黃色貓更普遍的特徵,但當你需要新的資料時,模型會生成一些綠貓的圖片,這樣原先的藍色毛皮貓特徵就會逐步消失,變成綠毛皮,接著再消失,變成黃毛皮。這就是模型崩塌。

避免方法

為了避免模型崩塌,有一些方法可以採取。首先有必要保留人工生成的原始資料,並避免讓 AI 生成的資料污染這些資料。然後,可以定期使用這些原始資料重新訓練模型,或者完全透過這些資料重新啟動訓練。第二種方法是將新的、乾淨的人工生成的資料回饋回訓練資料中,以降低 AI 模型所生成回應中的錯誤和重複。

此外由於 AI 模型很難從稀有事件中學習,而為了避免對少數族群的偏見,必須確保在資料集中充分代表少數族群,並且定期新增舊的和新的資料來重新訓練模型。這樣做可能會增加訓練成本,但這可以在一定程度上抵消模型崩塌的影響。

影響

這些發現對人工智慧領域具有重大意義,強調了需要改進方法,以維護生成模型的完整性。它們強調了不受約束的生成過程的風險,並且可以指導未來的研究以開發策略來預防或管理模型崩塌。未來人們生成的內容將會更加重要,因為它們可能成為 AI 模型培訓的重要資料源。這也意味著,當前 AI 技術的商業應用受制於此問題,在中長期內可能會受到影響。

結論

AI 技術的迅猛發展帶來了無限的機會,但同時也存在風險和挑戰。研究顯示當 AI 模型訓練基於其他 AI 模型生成的資料時,將導致模型崩塌問題,這會對未來技術發展施加巨大的影響。在使用 AI 技術的企業中,應當採取措施來避免這種問題的發生,這包括保留和使用原始的、乾淨的人工生成資料以及確保資料集中少數族群的公平代表性。隨著 AI 技術的不斷發展,我們也應考慮其潛在的風險和影響,從而制定更好、更全面的解決方案。

延伸閱讀

- Meta 員工探討使用版權內容進行 AI 訓練,背後隱祕曝光!

- Meta 暫停書籍授權以進行 AI 訓練,背後原因揭曉!

- 「馬斯克認同!我們已經耗盡 AI 訓練資料的邊界?」

- 「Avataar 全新工具上線!輕鬆打造 AI 生成產品影片!」

- 「Bluesky 宣布不會利用使用者發文訓練 AI,與 X 形成鮮明對比!」

- 科技巨頭對加州 AI 訓練透明度法案態度模糊,引發業界擔憂!

- Meta 是否利用智慧眼鏡照片來訓練 AI?祕密仍然未揭曉!

- YouTube 推出 AI 檢測工具!音樂與人臉識別新技術揭曉,創作者可掌握 AI 訓練控制權!

- YouTube Music 正測試 AI 生成的電臺功能,並新增歌曲識別工具

- YouTube 現在允許使用者要求移除模擬您的臉部或聲音的 AI 生成內容